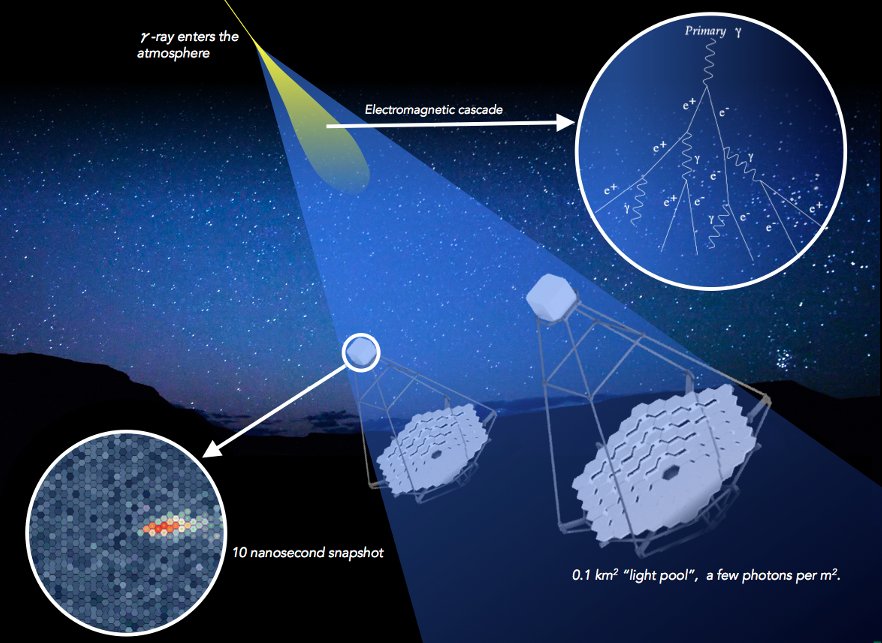

L’intelligence artificielle booste l’analyse des données de l’observatoire Cerenkov Telescope Array (CTA)

Pour traiter le volume colossal de données qui sera généré par le futur observatoire de rayons gamma de haute énergie CTA, un projet du LAPP nommé GammaLearn et mené par Thomas Vuillaume, développe un algorithme d’intelligence artificielle. Entrainé grâce à la puissance du supercalculateur Jean Zay, l’algorithme de deep learning pourra traiter les données en un temps et une efficacité records. L’objectif, à long terme, sera d’interpréter les évènements en temps réel pour émettre des alertes et faire converger plus rapidement les télescopes vers les sources cosmiques de signaux intéressants.

Détecter rapidement des événements parmi les centaines de gigaoctets qui seront générés chaque seconde par le futur observatoire Cherenkov Telescope Array (CTA), c’est le défi qu’une équipe du Laboratoire d’Annecy de Physique des Particules (LAPP) tente de relever en faisant appel à l’intelligence artificielle.

Plus précisément, Thomas Vuillaume (physicien au LAPP-IN2P3) et Mikaël Jacquemont (doctorant, LISTIC, USMB/LAPP-IN2P3), entendent exploiter la technologie du Deep Learning pour analyser les évènements détectés par les caméras de CTA. Leur projet se nomme GammaLearn et pour le développer ils se sont appuyés sur l’expertise du Laboratoire d’informatique, systèmes, traitement de l’information et de la connaissance (LISTIC)1 et Orobix, une entreprise privée d’ingénierie spécialisée dans les systèmes d’intelligence artificielle.

Les objectifs de GammaLearn

L’usage de l’intelligence artificielle se justifie à plus d’un titre pour CTA. Elle va améliorer la vitesse de tri et d’interprétation du flot de données brutes qui sera enregistré par les détecteurs. Mais surtout elle va simplifier le travail d’analyse. L’algorithme sera capable d’écarter, avec une précision inégalée, les événements indésirables du bruit de fond à partir de leurs images obtenues par les télescopes.

A terme, GammaLearn permettra aussi d’abaisser le seuil de détection des télescopes à basse énergie et distinguera avec une plus grande précision les photons gamma des autres particules cosmiques pour en déduire leurs paramètres (énergie, direction et point d’impact). Il pourra ensuite restaurer les données en stéréoscopie, c’est-à-dire combiner les images planes des rayons captés pour restituer les évènements en trois dimensions.

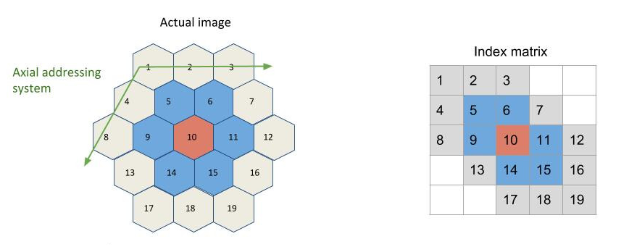

Cependant, il y a des contraintes techniques à prendre en considération. Par exemple, GammaLearn devra travailler à partir d’images « non conventionnelles » qui ne sont pas composées de pixels carrés mais hexagonaux. En effet, les logiciels d’apprentissage profond sont habituellement conçus pour travailler à partir de pixels carrés tandis que les images produites par plusieurs caméras de CTA ont un maillage hexagonal. Un pré-traitement est donc nécessaire durant lequel il n’est pas question de perdre la moindre information de pixel.

Dans un premier temps, l’équipe du LAPP a déterminé la structure du réseau de neurones (l’algorithme). Ils ont ensuite utilisé PyTorch, une bibliothèque open source de logiciels d'apprentissage automatique, pour effectuer les calculs et les abstractions nécessaires pour entraîner le réseau. Mais tout ceci n’était que le début du travail, car construire un algorithme n'est qu'une petite partie de l'ensemble d’un projet d’intelligence artificielle.

Le logiciel doit ensuite apprendre à analyser, traiter et trier les images tout seul. Comme le souligne Thomas Vuillaume : « Nous utilisons un type de réseau de neurones, dit de convolution, très gourmand en calculs. Le logiciel doit répéter plusieurs fois les procédures d’analyses pour parvenir à prendre les bonnes décisions lors du tri des évènements et de la reconstruction de leurs paramètres. C’est fastidieux mais nécessaire pour optimiser notre algorithme grâce à l’apprentissage profond ».

Dans le cas de GammaLearn, la puissance nécessaire à cette optimisation dépassait les ressources disponibles au Centre de Calcul de l’IN2P3, c’est pourquoi l’équipe s’est également tournée vers le supercalculateur Jean Zay pour entraîner l’algorithme et préparer le terrain aux futures analyses d’évènements cosmiques.

La contribution du supercalculateur Jean Zay

Installé sur le plateau de Saclay et inauguré en janvier 2020, le supercalculateur Jean Zay est l’un des plus puissants d’Europe. Il est spécialisé dans les calculs de haute performance (HPC) et possède une partition – c’est-à-dire un système permettant de gérer les informations de manière séparée – consacrée spécifiquement à l’intelligence artificielle (IA). Il est capable d’effectuer des simulations extrêmement complexes et peut calculer 16 millions de milliards (16 pétaflops) d’opérations par seconde. Sa partie dite « convergée », un mélange de processeurs classiques (les CPU) et de processeurs graphiques (les GPU), peut non seulement optimiser les simulations mais aussi utiliser l’IA pour aider les chercheurs à interpréter les images.

L’utilisation de Jean Zay par GammaLearn devrait se poursuivre au-delà de l’apprentissage. Ensemble ils auront la puissance suffisante pour reconstruire directement les évènements astrophysiques sans passer par les étapes de prétraitement, ce qui signifie que les données brutes pourront être transmises directement à l’ordinateur. Jean Zay sera une ressource importante avec 8000 heures de calculs attribués au projet.

Les perspectives à plus long terme

A plus long terme, les scientifiques ont pour ambition d’utiliser GammaLearn pour faire des analyses en temps réel et ainsi prévenir les autres télescopes de l’observatoire de se tourner vers un événement en cours. L’intelligence artificielle pourrait même, dans ce cas, servir de système d’alerte à l’attention des autres observatoires internationaux afin qu’ils puissent braquer rapidement leurs instruments vers les sources cosmiques intéressantes. GammaLearn est un bon candidat potentiel pour ce type d’analyse. Cependant « l’algorithme doit d’abord être longuement testé », précise Thomas Vuillaume, « et sa stabilité doit être éprouvée dans de nombreuses conditions d’observations afin que nous ayons suffisamment confiance en lui pour l’utiliser dans un système critique comme l’analyse en temps réel, où il n’y a pas de seconde chance ».

En attendant, l’équipe progresse dans la connaissance de l’instrument et l’ajustement de la chaine d’analyse de l’algorithme. La collaboration espère pouvoir faire les premiers tests sur les données réelles à l’aide de GammaLearn d’ici la fin de l’année.

- 1LISTIC : Unité de recherche de l’Université Savoie Mont Blanc (USMB). Leurs travaux portent sur la modélisation et le développement d’algorithmes pour extraire et gérer des connaissances notamment dans les domaines de l’observation de la Terre et du comportement humain.

Bibliographie

Jacquemont M., Vuillaume T., Benoit A., Maurin G., Lambert P. et al. :

« Multi-Task Architecture with Attention for Imaging Atmospheric Cherenkov Telescope Data Analysis », papier soumis pour le 25th International Conference on Pattern Recognition, en janvier 2021, Milan, Italie.

Jacquemont M., Vuillaume T., Benoit A., Maurin G., Lambert P., Lamanna G., Brill A. et al. :

« GammaLearn: a Deep Learning framework for IACT data », 36th International Cosmic Ray Conference, juillet 2019, Madison, United States.

Vuillaume T., Mikael J., Antiga, L., Benoit A., Lambert P., Maurin, G., & Silvestri G. et al. :

« GammaLearn-first steps to apply Deep Learning to the Cherenkov Telescope Array data », CHEP 2018 In EPJ Web of Conferences (Vol. 214, p. 06020). EDP Sciences.

Pour en savoir plus sur CTA et le supercalculateur Jean Zay

Sur le Cherenkov Telescope Array (CTA) :

-

Le Prototype LST-1 de CTA détecte une émission à très haute énergie en direction du Pulsar du Crabe (actualité du 23 juin 2020)

-

Cherenkov Telescope Array, un projet en cours de construction (actualité du 16 mai 2018)

Sur le supercalculateur Jean Zay :

-

Jean Zay, l’un des supercalculateurs les plus puissants d’Europe(actualité du 22 janvier 2020)